Temat został przeniesiony do archiwum

Ten temat przebywa obecnie w archiwum. Dodawanie nowych odpowiedzi zostało zablokowane.

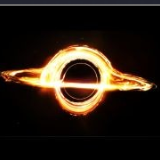

Intel Larrabee GPU

dodany przez

krzywymax, w Karty graficzne

Rekomendowane odpowiedzi

-

Ostatnio przeglądający 0 użytkowników

Brak zarejestrowanych użytkowników przeglądających tę stronę.